Komoditas paling berharga untuk bisnis saat ini adalah data. Karena organisasi dan individu terus menghasilkan data dalam jumlah besar per detik, menangkap data saja tidak cukup. Anda harus menganalisis, mengubah, dan mengekstrak wawasan yang bermakna dari data. Namun, nyaris 37 – 40% perusahaan menganalisis data mereka, dan 43% pembuat keputusan di perusahaan TI takut masuknya data yang berpotensi membanjiri infrastruktur data mereka.

Dengan kebutuhan untuk membuat keputusan cepat berdasarkan data dan mengatasi tantangan perbedaan sumber data, menjadi sangat penting bagi organisasi untuk mengembangkan infrastruktur data yang dapat menyimpan, mengekstrak, menganalisis, dan mengubah data secara efisien.

Ada kebutuhan mendesak untuk memiliki sistem yang dapat mentransfer data dari sumber ke sistem penyimpanan dan menganalisis serta memprosesnya secara real time. Pipa Data AI menawarkan hanya itu.

Apa itu Pipa Data?

Pipa data adalah sekelompok komponen yang mengambil atau menelan data dari sumber yang berbeda dan mentransfernya ke lokasi penyimpanan yang telah ditentukan sebelumnya. Namun, sebelum data ditransfer ke repositori, data tersebut mengalami pra-pemrosesan, penyaringan, standardisasi, dan transformasi.

Bagaimana pipeline data digunakan dalam pembelajaran mesin?

Pipeline menunjukkan otomatisasi alur kerja dalam project ML dengan mengaktifkan transformasi data ke dalam model. Bentuk lain dari pipa data untuk AI bekerja dengan membagi alur kerja menjadi beberapa bagian independen dan dapat digunakan kembali yang dapat digabungkan menjadi model.

Pipeline data ML memecahkan tiga masalah volume, pembuatan versi, dan variasi.

Dalam pipeline ML, karena alur kerja diabstraksikan ke dalam beberapa layanan independen, pengembang dapat merancang alur kerja baru hanya dengan mengambil dan memilih hanya elemen tertentu yang diperlukan sambil mempertahankan bagian lain seperti itu.

Hasil proyek, desain prototipe, dan pelatihan model didefinisikan selama pengembangan kode. Data dikumpulkan dari sumber yang berbeda, diberi label, dan disiapkan. Data berlabel digunakan untuk pengujian, pemantauan prediksi, dan penyebaran di tahap produksi. Model dievaluasi dengan membandingkan data pelatihan dan produksi.

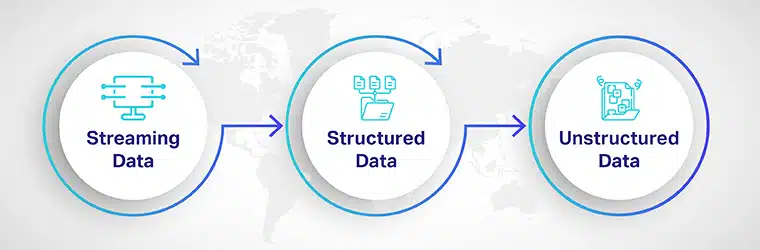

Jenis Data yang Digunakan oleh Pipelines

Model pembelajaran mesin berjalan pada sumber kehidupan pipa data. Misalnya, pipa data digunakan untuk pengumpulan data, membersihkan, memproses, dan menyimpan data yang akan digunakan untuk melatih dan menguji model. Karena data dikumpulkan dari sisi bisnis dan konsumen, Anda mungkin diminta untuk menganalisis data dalam berbagai format file dan mengambilnya dari beberapa lokasi penyimpanan.

Jadi, sebelum merencanakan tumpukan kode Anda, Anda harus mengetahui jenis data yang akan Anda proses. Jenis data yang digunakan untuk memproses pipeline ML adalah:

Data Streaming: Siaran langsung memasukan data digunakan untuk pelabelan, pemrosesan, dan transformasi. Ini digunakan untuk peramalan cuaca, prediksi keuangan, dan analisis sentimen. Data streaming biasanya tidak disimpan di a kumpulan data atau sistem penyimpanan karena diproses secara real-time.

Data terstruktur: Ini adalah data yang sangat terorganisir yang disimpan di gudang data. Data tabular ini mudah dicari dan diambil untuk analisis.

Data tidak terstruktur: Itu menyumbang hampir 80% dari semua data yang dihasilkan oleh bisnis. Ini termasuk teks, audio, dan video. Jenis data ini menjadi sangat sulit untuk disimpan, dikelola, dan dianalisis karena tidak memiliki struktur atau format. Teknologi terbaru, seperti AI dan ML, digunakan untuk mengubah data tidak terstruktur menjadi tata letak terstruktur untuk penggunaan yang lebih baik.

Bagaimana cara membuat pipeline data yang dapat diskalakan untuk melatih Model ML?

Ada tiga langkah dasar dalam membangun pipa yang dapat diskalakan,

Penemuan Data: Sebelum data dimasukkan ke dalam sistem, harus ditemukan dan diklasifikasikan berdasarkan karakteristik seperti nilai, risiko, dan struktur. Karena berbagai macam informasi diperlukan untuk melatih algoritme ML, data AI platform digunakan untuk menarik informasi dari sumber yang heterogen, seperti database, sistem cloud, dan input pengguna.

Penyerapan Data: Penyerapan data otomatis digunakan untuk mengembangkan pipeline data yang dapat diskalakan dengan bantuan webhook dan panggilan API. Dua pendekatan dasar untuk penyerapan data adalah:

- Penyerapan Batch: Dalam penyerapan batch, kumpulan atau grup informasi diambil sebagai respons terhadap beberapa bentuk pemicu, seperti setelah beberapa waktu atau setelah mencapai ukuran atau nomor file tertentu.

- Streaming Ingestion: Dengan streaming ingestion, data ditarik ke dalam pipeline secara real-time segera setelah dihasilkan, ditemukan, dan diklasifikasikan.

Pembersihan dan transformasi data: Karena sebagian besar data yang dikumpulkan tidak terstruktur, penting untuk dibersihkan, dipisahkan, dan diidentifikasi. Tujuan utama dari pembersihan data sebelum transformasi adalah untuk menghilangkan duplikasi, dummy data, dan data yang korup sehingga hanya tersisa data yang paling berguna.

Pra-pemrosesan:

Pada langkah ini, data yang tidak terstruktur dikategorikan, diformat, diklasifikasikan, dan disimpan untuk diproses.

Pemrosesan dan Manajemen Model:

Pada langkah ini, model dilatih, diuji, dan diproses menggunakan data yang diserap. Model disempurnakan berdasarkan domain dan kebutuhan. Dalam manajemen model, kode disimpan dalam versi yang membantu pengembangan model pembelajaran mesin lebih cepat.

Penerapan Model:

Pada langkah penerapan model, file kecerdasan buatan solusi dikerahkan untuk digunakan oleh bisnis atau pengguna akhir.

Saluran data – Manfaat

Pipelining data membantu mengembangkan dan menerapkan model ML yang lebih cerdas, lebih skalabel, dan lebih akurat dalam periode yang jauh lebih singkat. Beberapa manfaat dari pipeline data ML meliputi

Penjadwalan yang Dioptimalkan: Penjadwalan penting untuk memastikan model pembelajaran mesin Anda berjalan mulus. Saat ML meningkat, Anda akan menemukan bahwa elemen tertentu dalam pipeline ML digunakan beberapa kali oleh tim. Untuk mengurangi waktu komputasi dan menghilangkan cold start, Anda dapat menjadwalkan penerapan untuk panggilan algoritme yang sering digunakan.

Teknologi, kerangka kerja, dan kemandirian bahasa: Jika Anda menggunakan arsitektur perangkat lunak monolitik tradisional, Anda harus konsisten dengan bahasa pengkodean dan memastikan Anda memuat semua dependensi yang diperlukan secara bersamaan. Namun, dengan pipa data ML yang menggunakan titik akhir API, bagian kode yang berbeda ditulis dalam beberapa bahasa berbeda dan menggunakan kerangka kerja spesifiknya.

Keuntungan utama menggunakan pipeline ML adalah kemampuan untuk menskalakan inisiatif dengan memungkinkan potongan model digunakan kembali berkali-kali di seluruh tech stack, terlepas dari framework atau bahasanya.

Tantangan Pipa Data

Menskalakan model AI dari pengujian dan pengembangan hingga penerapan tidaklah mudah. Dalam skenario pengujian, pengguna bisnis atau pelanggan mungkin jauh lebih menuntut, dan kesalahan semacam itu mungkin merugikan bisnis. Beberapa tantangan pemipetan data adalah:

Tantangan pembersihan dan persiapan: Terlepas dari tantangan teknis perpipaan data, ada tantangan pembersihan dan persiapan data. itu data mentah harus disiapkan dalam skala besar, dan jika pelabelan tidak dilakukan secara akurat, ini dapat menyebabkan masalah dengan solusi AI.

Tantangan organisasi: Ketika teknologi baru diperkenalkan, masalah besar pertama muncul di tingkat organisasi dan budaya. Kecuali jika ada perubahan budaya atau orang-orang dipersiapkan sebelum implementasi, hal itu dapat berarti malapetaka bagi pipa AI proyek.

Keamanan data: Saat menskalakan proyek ML Anda, memperkirakan keamanan dan tata kelola data dapat menimbulkan masalah besar. Sejak awal, sebagian besar data akan disimpan di satu tempat; mungkin ada masalah dengan itu dicuri, dieksploitasi, atau membuka kerentanan baru.

Membangun pipeline data harus selaras dengan tujuan bisnis Anda, persyaratan model ML yang dapat diskalakan, serta tingkat kualitas dan konsistensi yang Anda perlukan.

Menyiapkan saluran data yang dapat diskalakan untuk model pembelajaran mesin dapat menantang, memakan waktu, dan kompleks. Shaip membuat seluruh proses lebih mudah dan bebas dari kesalahan. Dengan pengalaman pengumpulan data kami yang luas, bermitra dengan kami akan membantu Anda mengirimkan lebih cepat, berkinerja tinggi, terintegrasi, dan solusi pembelajaran mesin end-to-end di sebagian kecil dari biaya.